首先说明一下,本文的安装教程仅是针对个人的操作经验所写的。可能有些同学安装的时候觉得跟他的不一样,那可能是由于版本不一样所导致的。另外本次分享是基于已经安装了java及配置好了环境。

本机的配置环境如下: Hadoop(3.1.1) Ubuntu Linux(64位系统)

一、安装ssh服务

ubuntu中默认是没有安装ssh server的,只有 ssh client,可以使用如下命令安装: sudo apt-get install ssh openssh-server 然后设置ssh免密码登陆,执行如下命令:

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

#验证是否成功 输入

ssh localhost

#如果可以不需要密码登录则表示成功,否则就是失败,需要去查找原因,如果成功后 输入exit退出

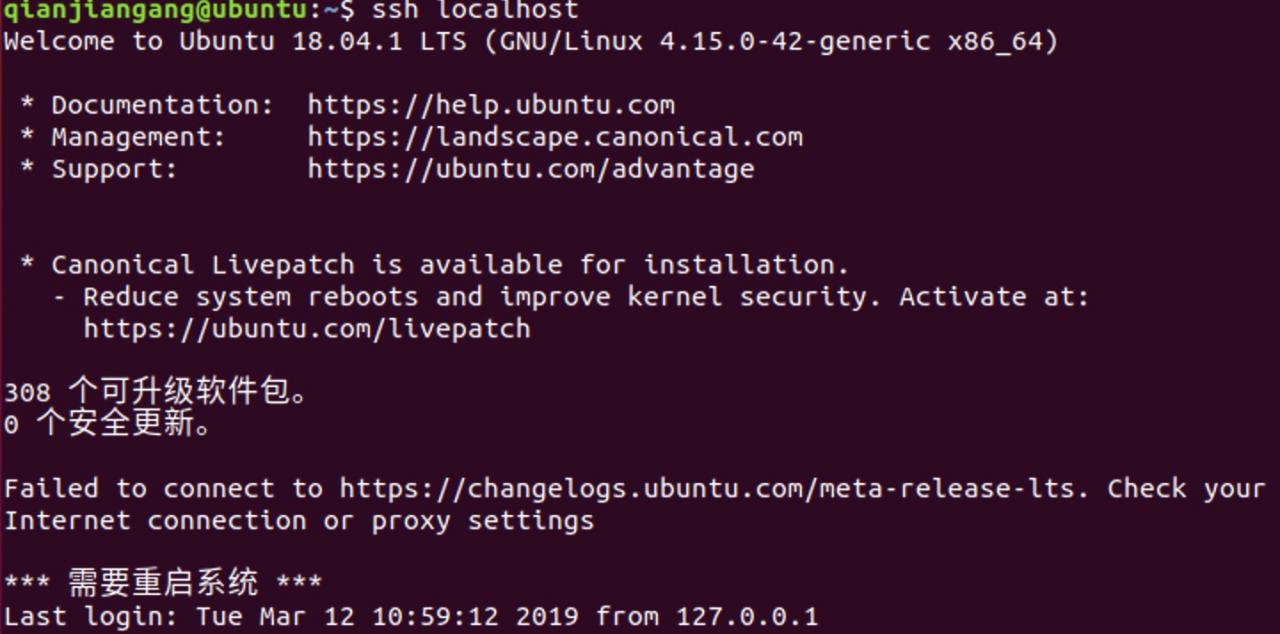

成功之后截图如下:

二、安装Hadoop

1.下载Hadoop安装包 可以到如下网址下载:http://apache.stu.edu.tw/hadoop/common/hadoop-3.1.1/

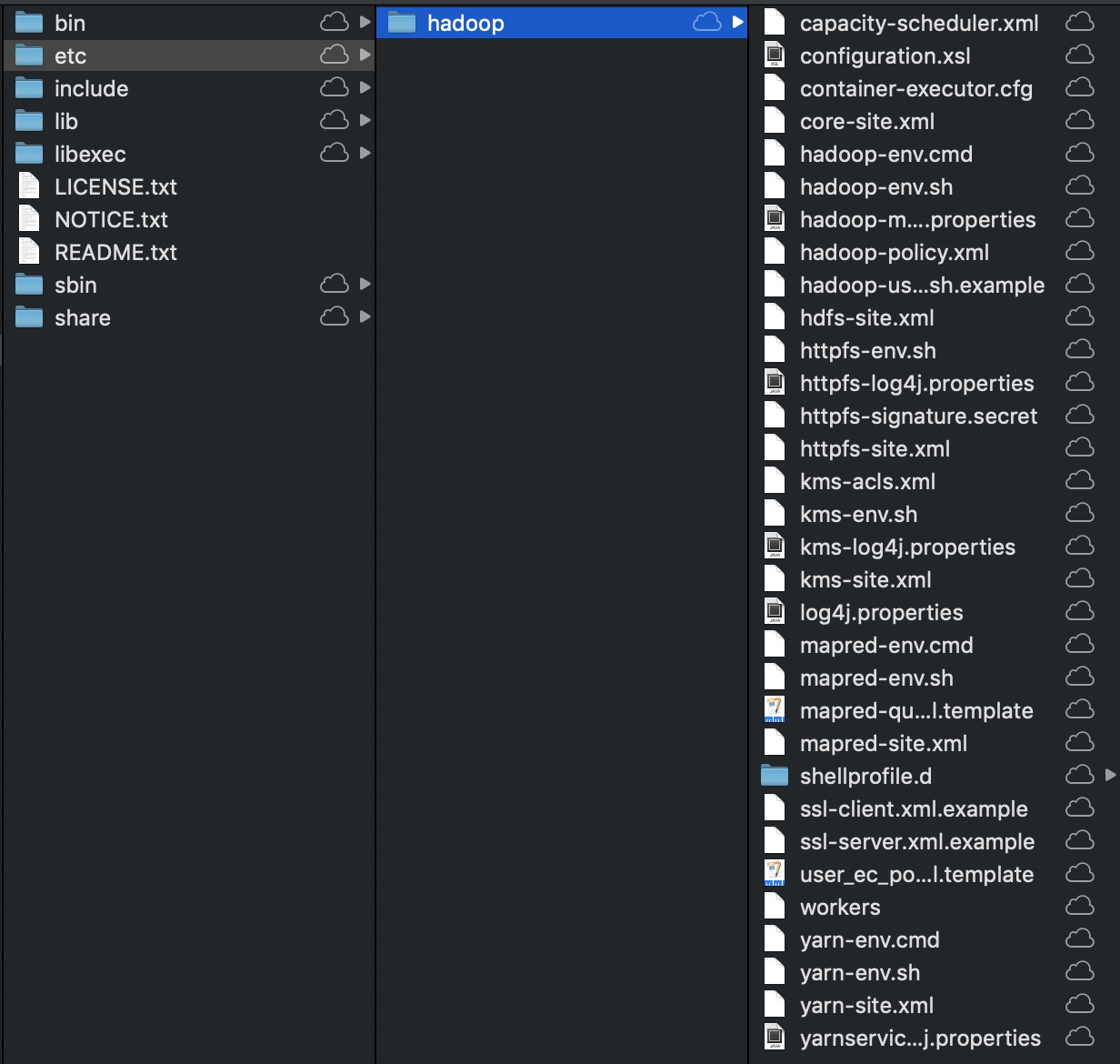

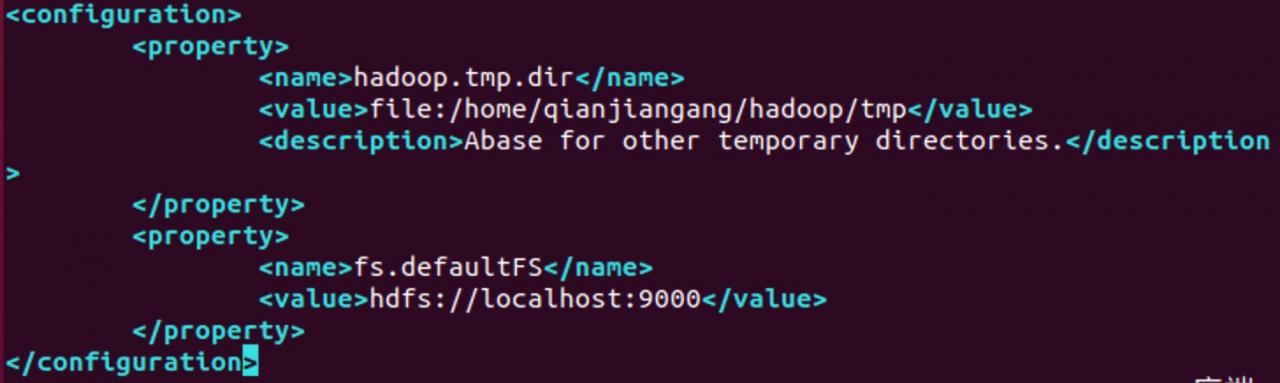

2.解压 使用如下命令解压缩Hadoop安装包: tar -zxvf hadoop-3.1.1.tar.gz 解压完成之后出现Hadoop-3.1.1的文件下如下:  3.配置Hadoop中相应的文件 我使用的是Hadoop的伪分布式,因此需要配置的文件如下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml,所有的文件均位于hadoop3.1.1/etc/hadoop下面,具体需要的配置如下: (1)core-site.xml 配置如下:

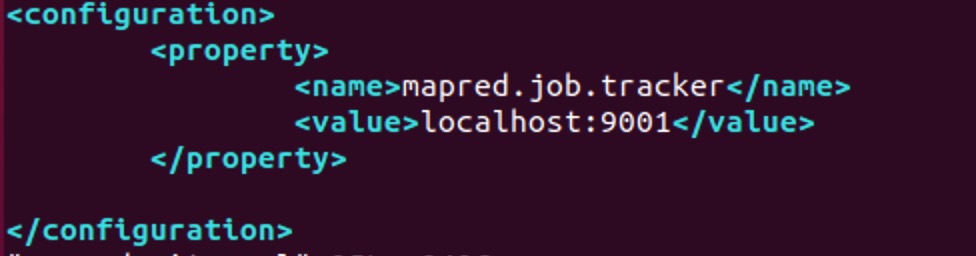

3.配置Hadoop中相应的文件 我使用的是Hadoop的伪分布式,因此需要配置的文件如下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml,所有的文件均位于hadoop3.1.1/etc/hadoop下面,具体需要的配置如下: (1)core-site.xml 配置如下:  (2)mapred-site.xml.template配置如下:

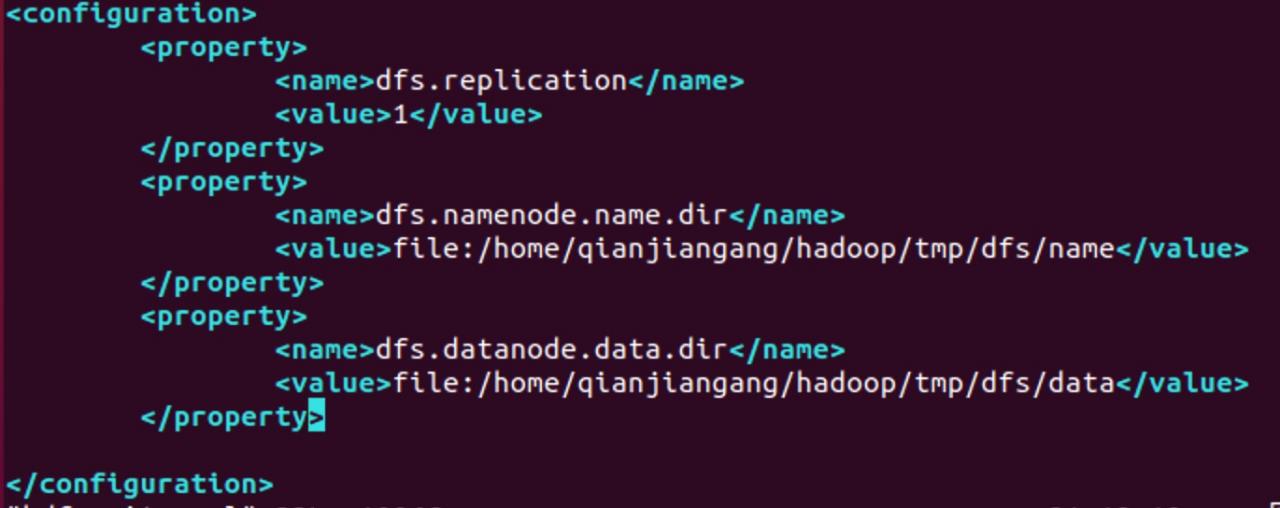

(2)mapred-site.xml.template配置如下:  (3)hdfs-site.xml配置如下:

(3)hdfs-site.xml配置如下:

注:如果运行Hadoop的时候发现找不到jdk,可以先使用echo $JAVA_HOME查看java安装路径,然后直 接将jdk的路径放置在hadoop.env.sh里面。具体如下:

接将jdk的路径放置在hadoop.env.sh里面。具体如下: export JAVA_HOME="/usr/lib/jvm/java-11-openjdk-amd64"

三、运行Hadoop

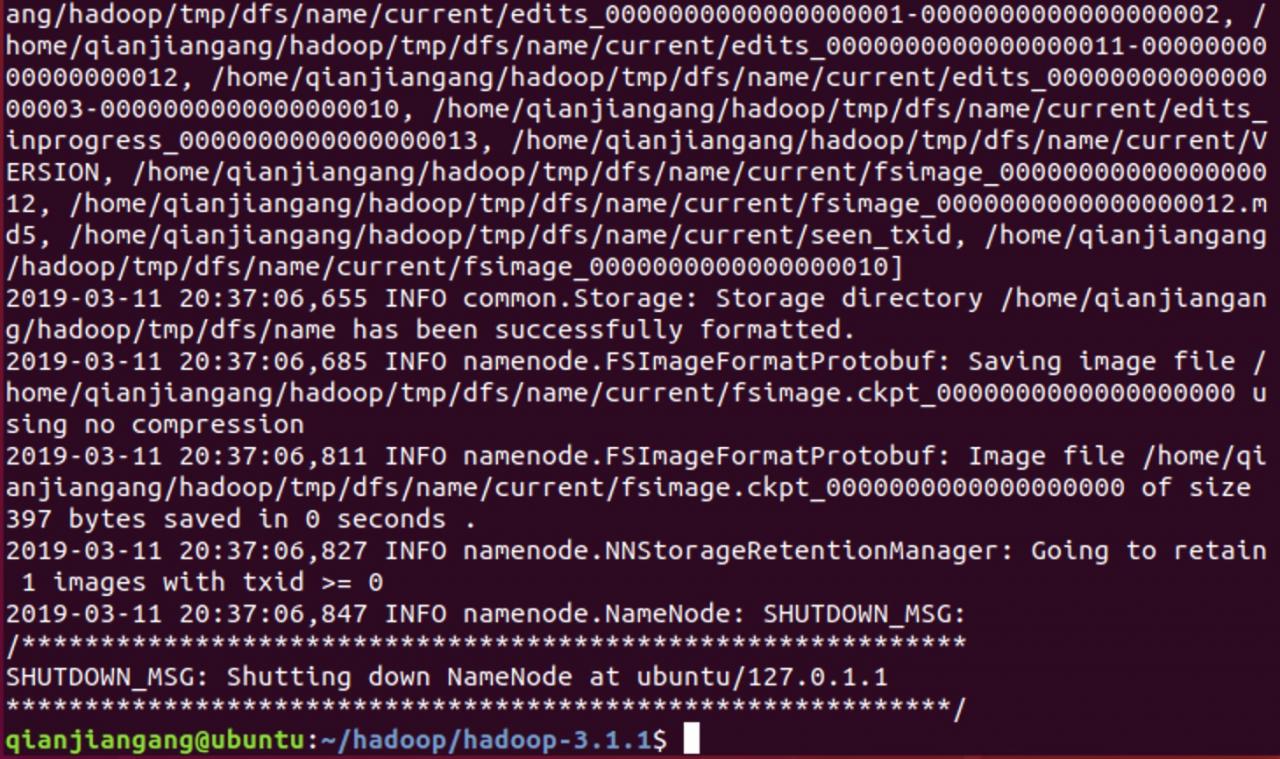

1.首先你需要初始化HDFS系统 在hadop3.1.1目录下使用如下命令: bin/hdfs namenode -format 成功之后截图如下:  表示已经初始化完成。 2.开启NameNode和DataNode守护进程 在hadop3.1.1目录下使用如下命令:

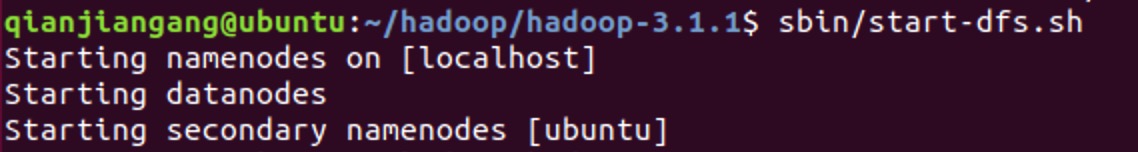

表示已经初始化完成。 2.开启NameNode和DataNode守护进程 在hadop3.1.1目录下使用如下命令: sbin/start-dfs.sh 成功之后截图如下:  3.查看进程信息 在hadop3.1.1目录下使用如下命令:

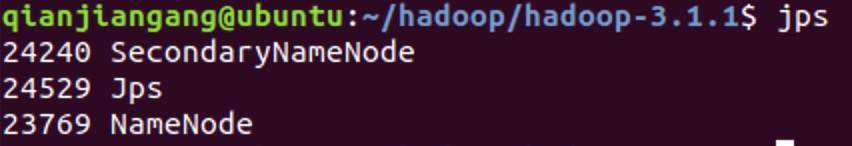

3.查看进程信息 在hadop3.1.1目录下使用如下命令: jps 成功之后截图如下:  4.查看Web UI 在浏览器中输入http://localhost:50070,即可查看相关信息。但是有些同学可能出现访问不了50070端口的问题。你可以在终端使用

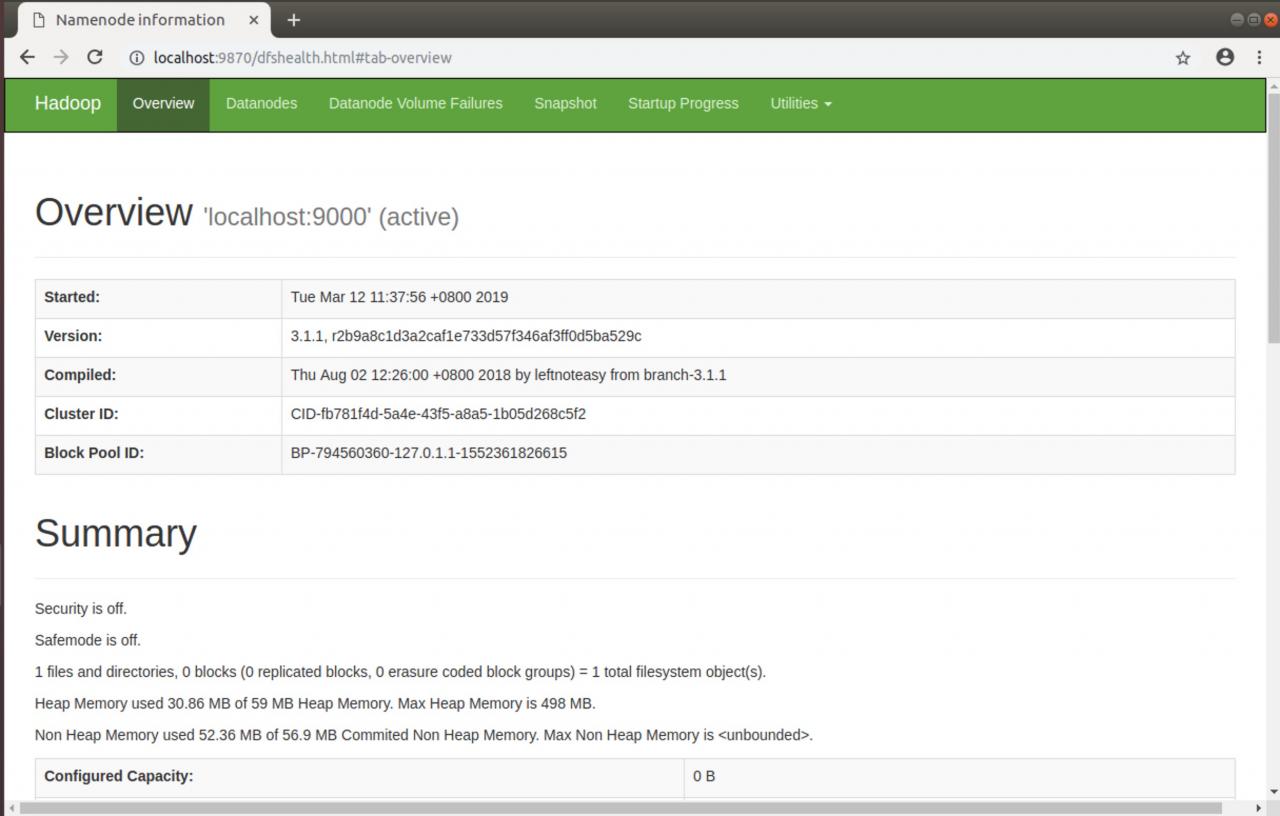

4.查看Web UI 在浏览器中输入http://localhost:50070,即可查看相关信息。但是有些同学可能出现访问不了50070端口的问题。你可以在终端使用netstat -ntlp查看一下服务器启动的端口。  然后一个个尝试,我最终找到的HDFS nameNode 的登陆端口是9870 成功之后的截图如下:

然后一个个尝试,我最终找到的HDFS nameNode 的登陆端口是9870 成功之后的截图如下:  至此,hadoop的环境就已经搭建好了。

至此,hadoop的环境就已经搭建好了。